개요

Zabbix + VMware의 모니터링 설정하여

호스트에서 나타나는 얼럿과 VM들의 얼럿에 대해 모니터링 하고자 하였다.

1. zabbix_server.conf 설정

### Option: StartVMwareCollectors

# Number of pre-forked vmware collector instances.

StartVMwareCollectors=5

### Option: VMwareFrequency

# How often Zabbix will connect to VMware service to obtain a new data.

VMwareFrequency=60

### Option: VMwarePerfFrequency

# How often Zabbix will connect to VMware service to obtain performance data.

VMwarePerfFrequency=60

### Option: VMwareCacheSize

# Size of VMware cache, in bytes.

# Shared memory size for storing VMware data.

# Only used if VMware collectors are started.

VMwareCacheSize=8M

### Option: VMwareTimeout

# Specifies how many seconds vmware collector waits for response from VMware service.

VMwareTimeout=102. Create Host

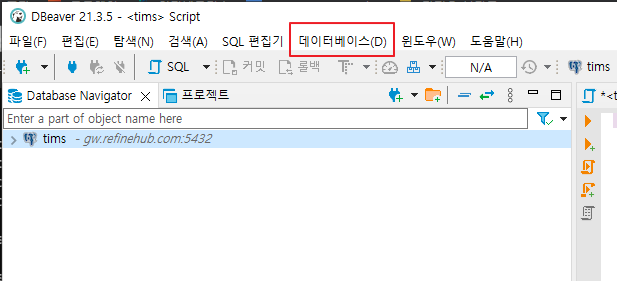

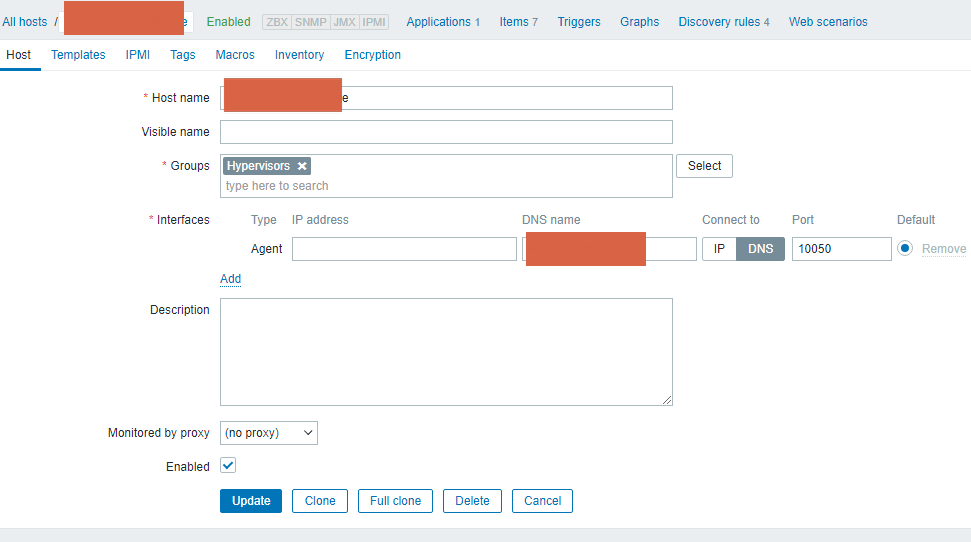

Zabbix WebUI에서 호스트 생성

Group은 Hypervisors로 등록. 해당 그룹안에 Template VM VMware라는 템플릿이 Linked 되어 있다.

그러므로 해당 템플릿으로 Discovery 하여 VM들에 대한 것 까지 긁어서 모니터링 할 수 있다.

3. Host 생성 과정 중 Macros 탭에서 설정

vCenter 서버 나 ESXi 서버에 대한 정보를 넣는다.

url 뒤에는 /sdk 를 붙인다.

4. Zabbix 서버와 VMware 서버 간 방화벽 포트 오픈

10050, 10051, 443 포트에 대해 양방향 오픈 필요

5. zabbix server 서비스 리스타트

systemctl restart zabbix-server.service

6. 확인

위 처럼 Host와 VM까지 다 긁어오는 것을 확인 해 볼 수 있다.

불러오는 시간이 길어 질 수 있음 (넉넉히 1~2시간 잡아라)

'IT > Zabbix' 카테고리의 다른 글

| MySQL ibdata1 용량 클리어 작업 (with Zabbix) (0) | 2022.02.18 |

|---|---|

| (최신) Amazon Linux 2 Zabbix Server 5.0 설치 (0) | 2022.01.17 |

| Zabbix agent on Windows Server (0) | 2021.08.17 |

| Zabbix 감시 설정 (0) | 2021.07.29 |

| Zabbix Template 설정 (0) | 2021.07.29 |